2018 年,随着 RTX 技术和首款专为 AI 打造的消费级 GPU (GeForce RTX) 的推出,NVIDIA 加速了向 AI 计算的转变。从那时起,基于 RTX PC 和工作站的 AI 蓬勃发展,目前已成为拥有超过 1 亿用户和 500 款 AI 应用的生态系统。

如今,无论 PC 还是云端,生成式 AI 都在开创全新的可能。NVIDIA 在 AI 领域深耕多年,拥有毋庸置疑的专业性,为所有用户提供强劲性能,轻松应用各种 AI 功能。

无论是居家还是办公,在使用提升工作效率和娱乐体验的软件时,都能充分利用 RTX AI 的力量。得益于GeForce RTX GPU 提供的AI特性 — 游戏玩家可以在更高分辨率下,以更高帧率畅玩钟爱的游戏;创作者则可专注于创意本身,而无需在等待系统加载或重复乏味工作上浪费时间;开发者亦可以使用生成式 AI 进行原型设计和自动化调试,从而简化工作流。

AI 领域正在快速发展。随着研究的深入,AI 将可处理更复杂的任务。这些严苛的性能要求将交由 RTX 来满足。

什么是 AI ?

就其最基本的定义而言,人工智能 (AI) 是一种更智能的计算类型。计算机程序或机器无需使用命令进行显式编码,便可思考、学习和采取行动的能力即为 AI。

可将 AI 视为开发以下计算机系统的过程:用于自主执行任务、摄入和分析海量数据,然后在这些数据中识别模式的系统。

庞大且不断发展的 AI 研究领域始终围绕系统开发,这些系统能够以超出任何个人或团队能力的速度,来执行原本需要人类智慧才能完成的任务。因此,AI 被广泛认为颇具颠覆性和高度变革性。

AI 系统的基本准则是:在新信息和新数据输入这些系统时自行调整,从而实际学习之前的经验或从数据中学习模式。这种自主学习能力让 AI 系统能够完成种类繁多的任务,包括图像识别、语音识别、语言翻译、医疗诊断、汽车导航、图像和视频增强以及数百种其他用例。

AI 进化的下一阶段是内容生成,即生成式 AI。它使用户能够快速创建新内容,并根据各种输入 (包括文本、图像、声音、动画、3D 模型或其他类型的数据) 对其进行迭代。然后,生成式 AI 便会以相同形式或新形式生成新内容。

基于云端部署的 ChatGPT 等热门语言类应用允许用户通过简短的文本请求生成长篇文案。图像生成器如Stable Diffusion可将描述性文本输入转换为所需图像。新的应用可通过文本生成视频,将 2D 图像转换为 3D 渲染图。

GeForce RTX AI PC 和 NVIDIA RTX 工作站

AI PC 是搭载专用AI加速硬件的计算机。有无专用加速硬件带来的体验天差地别。没有专用硬件加速,只能空等 3D 图像加载完成,通过 AI Denoiser 可做到所见即所得。

在 RTX GPU 上,这些专用的 AI 加速器被称为 Tensor Core。在运行要求极为严苛的工作和娱乐应用时,Tensor Core 能够显著加速 AI 性能。

衡量 AI 性能的一种方法是以 teraops 为单位。teraops 即“万亿次运算/秒”(TOPS)。与发动机的马力等级类似,TOPS 可作为单一指标让用户了解 PC 的 AI 性能。这一代GeForce RTX GPU可提供的算力,涵盖了从200 AI TOPS到1300 AI TOPS,包括笔记本电脑和台式电脑的多样选择。

与之相比,目前没有独立 GPU 的 AI PC 的算力仅为 10 至 45 TOPS。

面对越来越多的 AI 应用类型,用户将需要一台能够在本地(即在设备上而非在云端运行)执行特定 AI 任务的 PC。AI PC 的优势在于:无需联网,算力触手可及;无需等待,高响应低延迟;无需上传,更安全更放心。

面向每个人的 AI

RTX GPU 不仅带来了强劲性能,还带来了 RTX 技术特有的功能。这些AI 功能面向所有用户,意义重大。

从可提升视频会议体验的AI超采样,再到智能且个性化的聊天机器人,各种类型的用户都能从 AI 中受益。

RTX Video 可使用 AI 对流媒体视频进行超采样并以 HDR 显示该视频,从而将 SDR 低分辨率视频转成生动的 HDR 视频,分辨率最高可提升至 4K。只需单击一下,RTX 用户即可一劳永逸地为几乎所有Chrome 或 Edge 浏览器中播放的视频启用该功能。

NVIDIA Broadcast 是一款面向 RTX 用户的免费应用,其界面简洁明了,具有一系列可改善视频会议和直播体验的 AI 功能。该应用可通过噪音消除和房间回声消除功能消除多余的背景音,如键盘敲击声、吸尘器声和孩童尖叫声。该应用也可利用虚拟背景功能,通过更好的边缘检测技术来替换背景或使背景模糊。该应用还能利用消除视频干扰功能,使低画质摄像头图像中的图形轮廓变得更平滑。此外,无论用户向何处移动,该应用都能通过自动聚焦和目光接触功能,让用户保持在画面中央,并让用户的眼睛看起来像是在直视摄像头。

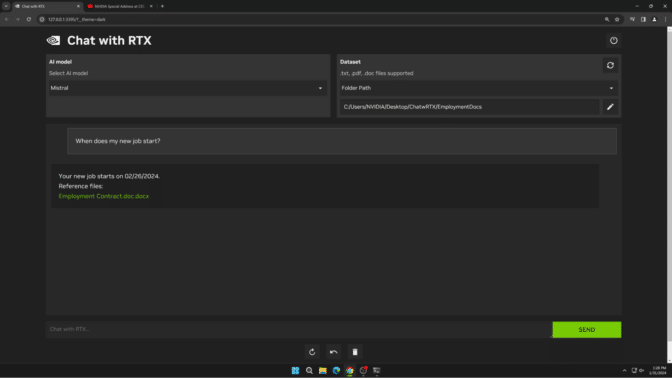

Chat with RTX 是一款能在本地运行的个性化 AI 聊天机器人示例,不仅易于使用,还可免费下载。

该技术演示于今年 1 月发布,不久后将更新与 Google Gemma 有关的内容。

该技术演示于今年 1 月发布,不久后将更新与 Google Gemma 有关的内容。

用户只需将文件放入单个文件夹,并为 Chat with RTX 指明该文件夹的位置,即可轻松将 PC 上的本地文件连接到受支持的大语言模型。之后,用户便可以快速查询与上下文相关的内容。

由于 Chat with RTX 运行在 GeForce RTX PC 和 NVIDIA RTX 工作站的本地 Windows 上,因此其运行速度很快,同时用户的数据也无需传输至其他地方。Chat with RTX 并不依赖基于云的服务,用户可以在本地 PC 上处理敏感数据,因此无需与第三方共享数据或连接互联网。

面向游戏玩家的 AI

在过去六年间,游戏性能在 AI 加速的助力下实现了巨大飞跃。自 2019 年以来,各路游戏玩家一直都在利用 NVIDIA DLSS 提高帧率和改善画质。NVIDIA DLSS 是一种利用 AI 在游戏中自动生成像素的技术。经过不断改进,这项技术现在最多可使帧率提升至原来的 4 倍。

随着最新版本 DLSS 3.5 引入光线重建功能,一些全球热门游戏的画质得到了进一步提升,为视觉效果更丰富、更具沉浸感的游戏体验设立了新标准。

目前,已有超过 500 款游戏和应用通过光线追踪、DLSS 和 AI 赋能技术革新了用户的游戏和创作方式。

除了提升帧率以外,AI 还可改进游戏玩家与游戏内角色的交互方式,以及开发人员重制经典游戏的方式。

在 NVIDIA ACE 微服务 (包括由生成式 AI 赋能的语音和动画模型) 的助力下,开发者能够为游戏添加生动的智能数字化虚拟形象。在 CES 上亮相的 ACE 赢得了多个奖项,因为它能让游戏角色栩栩如生,让人看到 PC 游戏的未来。

NVIDIA RTX Remix 是一款面向 Modder 的平台,可提供各种生成式 AI 工具,以便将经典游戏的基本纹理转换为基于物理特性渲染的全新 4K 分辨率材质。Modder 可通该平台打造令人惊艳的经典游戏 RTX 重制版。现有数个重制版项目已经发布或正处于开发中,包括“半条命 2 (Half-Life 2)”RTX 版和“传送门 (Portal)”RTX 版。

面向创作者的 AI

AI 可减少或自动执行繁琐的任务,让创作者腾出时间进行纯粹的创作,从而释放其创造潜力。以下功能在配备 NVIDIA RTX 或 GeForce RTX GPU 的 PC 上运行速度更快,甚至有些功能仅能在此类设备上运行。

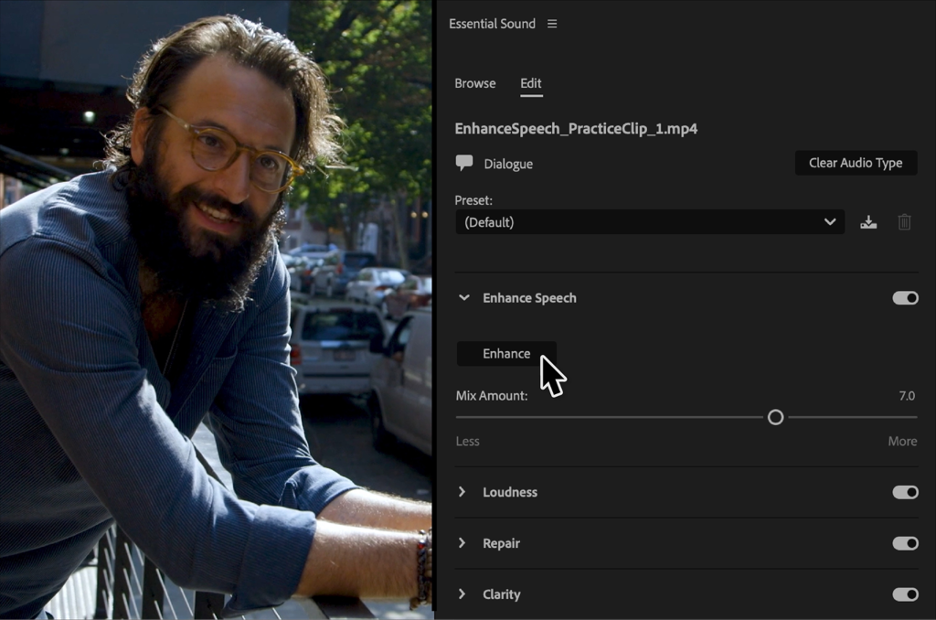

Adobe Premiere Pro 的 AI 能增强语音工具消除多余的噪音并提高对话质量。

Adobe Premiere Pro 的 AI 能增强语音工具消除多余的噪音并提高对话质量。

Adobe Premiere Pro 的“增强语音”工具由 RTX 加速,可利用 AI 消除多余的噪音并提高对话片段的质量,使其听起来像是专业录制。该工具在 RTX 设备上运行的速度是在Mac 上的 4.5 倍。自动重构 (Auto Reframe) 是 Premiere 的另一项功能,它可利用 GPU 加速来识别和追踪视频中更具相关性的元素,并针对不同的高宽比智能地重构视频内容。

DaVinci Resolve 的魔术遮罩功能是另一项可为视频剪辑师节省时间的 AI 功能。以前,如果剪辑师需要调整镜头中主体的色彩/亮度或移除多余的物体,他们必须结合使用多种转描技术或基本的 Power Window 和遮罩,才能将主体与背景分离。

魔术遮罩功能彻底改变了这个工作流。借助魔术遮罩,用户只需在主体上绘制一条线即可,之后 AI 会进行片刻的处理,然后显示应选择的区域。此外,GeForce RTX 笔记本电脑运行该功能的速度是最快的非 RTX 系列笔记本电脑的 2.5 倍。

AI 为创意加速的方式多种多样,以上只是一个示例而已。目前,已有超过 125 款由 RTX 加速的 AI 应用。

面向开发者的 AI

借助可扩展的环境、硬件和软件优化以及全新 API,AI 正在改进开发者构建软件应用的方式。

NVIDIA AI Workbench 可帮助开发者利用 PC 级性能和内存占用来快速创建、测试和自定义预训练生成式 AI 模型和 LLM。这是一个易于使用的统一工具包,可运行在本地 RTX PC 上,也可扩展到几乎所有数据中心、公有云或 NVIDIA DGX 云 上。

在为 PC 用例构建 AI 模型后,开发者可以使用 NVIDIA TensorRT 来对模型进行优化。该软件可帮助开发者充分利用 RTX GPU 中的 Tensor Core。

借助 TensorRT-LLM for Windows,TensorRT 加速现可用于基于文本的应用。TensorRT-LLM for Windows 是一个开源代码库,可提升 LLM 性能,并包含适用于热门模型(包括 Google Gemma、Meta Llama 2、Mistral 和 Microsoft Phi-2)且经过预先优化的模型文件。

开发者还可以使用为 OpenAI Chat API 准备的 TensorRT-LLM 封装。只需修改一行代码,continue.dev (一种能够利用 LLM 的开源autopilot程序,适用于 VS Code 和 JetBrains) 就可以在RTX PC 上使用 TensorRT-LLM 加速本地 LLM 推理。

每周,我们都会揭秘 AI,方便更多人掌握相关技术,并为 RTX AI PC 用户展示全新硬件、软件、工具和加速功能。

AI 的 iPhone 时刻已经到来,而这仅仅只是开始。欢迎关注《解码 AI》专栏。