ResNet-50 训练,数据集:ImageNet2012,BS=256 | NVIDIA V100 比较数据:NVIDIA DGX-2™ 服务器,1 枚 V100 SXM3-32GB 显卡,MXNet 1.5.1,container=19.11-py3,混合精度,吞吐量:1,525 张图像/秒 | 英特尔比较数据:Supermicro SYS-1029GQ-TRT,单路英特尔金牌 6240 处理器(2GHz/3.9Hz Turbo 频率),Tensorflow 0.18,FP32(仅提供精度),吞吐量:48 张图像/秒

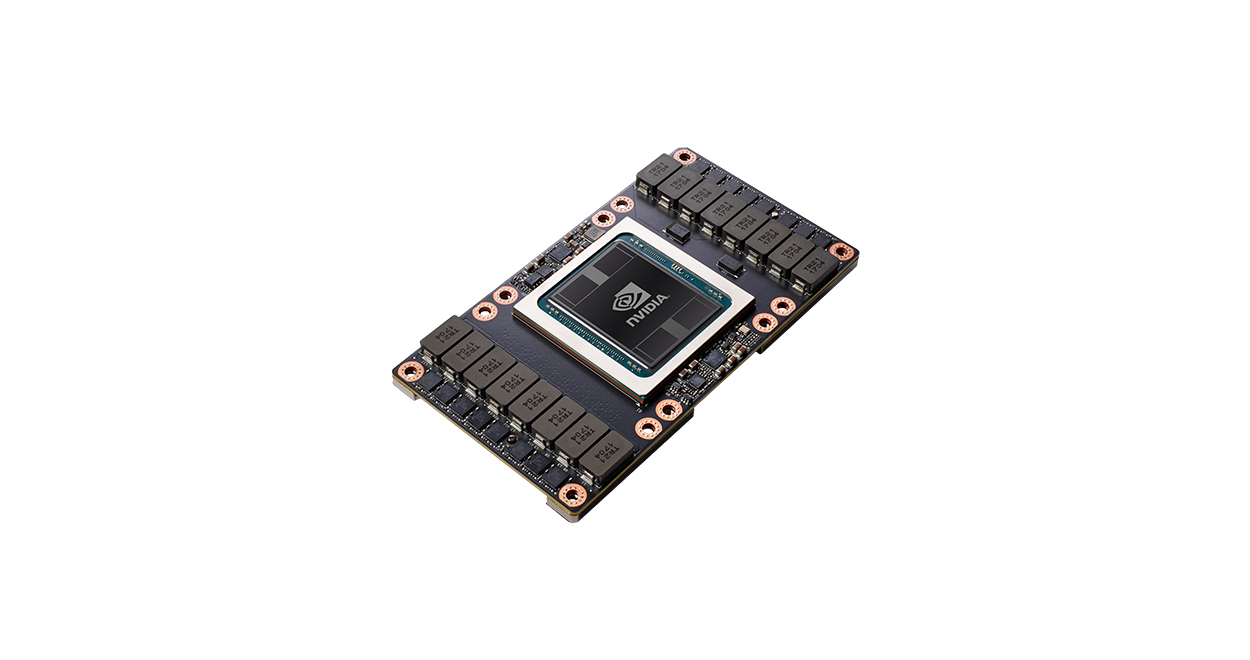

NVIDIA V100 TENSOR CORE GPU

首款搭载 Tensor 核心 GPU